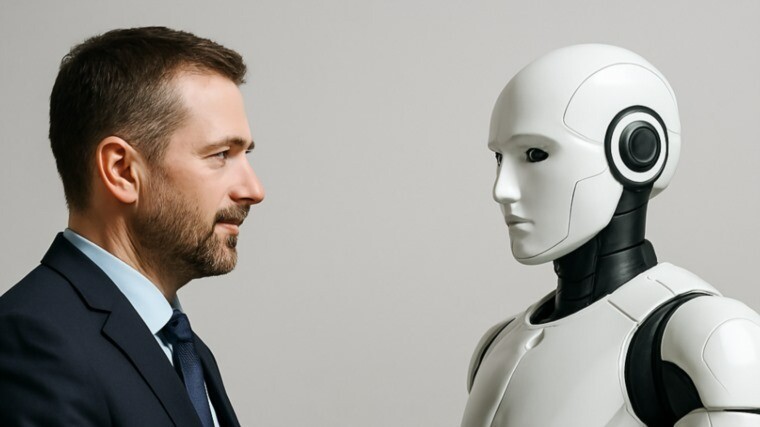

كشفت دراسة أجرتها جامعة كاليفورنيا، سان دييغو، أن نماذج الذكاء الاصطناعي GPT‑4.

5 من OpenAI وLlama‑3.1‑405B من Meta، تمكّنت من اجتياز نسخة متقدمة من اختبار تورينغ، إذ أخطأ البشر في التمييز بينها وبين الإنسان في محادثات قصيرة.

السر كان في استخدام مُوجهات شخصية تُعرف بـ"PERSONA"، تُضفي على النماذج طابعًا بشريًا واقعيًا مليئًا بالعواطف والتفاصيل اليومية. GPT‑4.5 تم اعتباره إنسانًا في 73% من الحالات، بينما بلغت نسبة خداع Llama‑3.1‑405B نحو 56%، مقابل 21% فقط لـ GPT‑4o عند استخدام تعليمات بسيطة.

أشار الباحثون إلى أن نجاح الذكاء الإصطناعي، لا يعود فقط إلى قوة النماذج، بل لقدرتها على "تجسيد هوية" مقنعة. ولكن عند إزالة هذه الشخصيات، تراجع أداء GPT‑4.5 إلى 36%، ما يؤكد أهمية التخصيص.

ورغم هذا التقدم، يظل اختبار تورينغ محط جدل، إذ يراه البعض مقياسًا لمحاكاة ناجحة لا لذكاء حقيقي. ويبقى السؤال: "هل هذه النماذج تُفكر فعلاً، أم أنها ببساطة بارعة في تقليد الإنسان؟"